La IA generativa tomó al mundo por sorpresa en 2023 y no muestra signos de desaceleración en 2024. A medida que los large language models (LLMs) continúan demostrando su habilidad para crear y utilizar datos no estructurados, es primordial que la industria de seguros explore y se involucre con estas capacidades de IA en evolución.

Combinados con nuevas técnicas, como la generación aumentada por recuperación (RAG, por sus siglas en inglés) y la ingeniería de prompts, los LLMs podrían producir significativos ahorros de costos relacionados con manuales de suscripción, procedimientos de resolución de reclamaciones, y documentos y comunicaciones de pólizas. Aquí, destacamos varios avances clave en LLMs y detallamos cómo los usuarios pueden aplicar más efectivamente estas nuevas tecnologías dentro de la industria de seguros.

¿Qué hay de nuevo con los LLMs?

Una de las características emergentes entre los LLMs es su capacidad para manejar diferentes tipos de modalidades de entrada. Mientras que comunicarse con versiones anteriores de ChatGPT había estado limitado a interacciones basadas en texto, GPT-4 permite a los usuarios subir documentos con sus prompts, permitiendo así que el modelo asista con tareas basadas en imágenes o responda preguntas sobre archivos CSV específicos. Equipar a los LLMs con múltiples tipos de información debería empoderarlos para producir respuestas más matizadas adaptadas a las necesidades específicas de un usuario individual.

Este nivel elevado de personalización en las entradas del modelo se complementa aún más con mejoras que otorgan a los usuarios un mayor control sobre las respuestas generadas por los LLMs. Por ejemplo, GPT-4 puede designar si sus respuestas deben estar en formato JSON u otro tipo de archivo estructurado, mejorando en gran medida la fiabilidad y consistencia. Esta capacidad es particularmente útil para el desarrollo web, análisis de datos y aprendizaje automático – funciones que ya están siendo optimizadas por los LLMs y es probable que incluso haya una mayor automatización a medida que estos modelos se transformen en plataformas generativas de IA independientes. ChatGPT está a la vanguardia de esta transformación, dado que GPT-4 puede ejecutar código y realizar búsquedas web en tiempo real. A medida que los LLMs avanzan en 2024, también lo hará su potencial para abordar una variedad de tareas relacionadas con seguros.

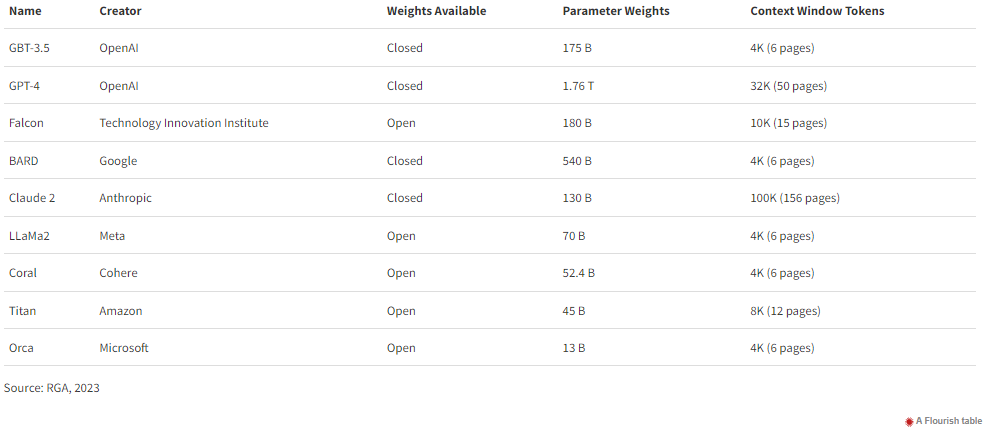

Modelos LLM Populares a 31 de diciembre de 2023

Casos de uso en seguros

Los LLMs podrían servir como una herramienta clave para muchas facetas de la industria de seguros, incluyendo evaluaciones actuales, documentación de pólizas y suscripción. Los actuarios podrían usar LLMs para generar código que aumentará el modelado predictivo. Además, la capacidad de subir datos de usuarios podría ser útil para explorar las relaciones entre variables y extraer conocimientos clave, lo que finalmente puede llevar a mejores modelos de riesgo.

Las capacidades de procesamiento de lenguaje natural de los LLMs podrían facilitar una variedad de tareas:

- Los profesionales de seguros podrían usar modelos para asegurar consistencia a través de las pólizas, mejorar la legibilidad y realizar traducciones multilingües. Claude 2 de Anthropic es actualmente el LLM que puede procesar la mayor cantidad de texto dentro de un solo prompt.

- Usando técnicas más avanzadas, los LLMs podrían ayudar a asegurar que los documentos de pólizas se adhieran a estándares regulatorios o requisitos legales.

- Los suscriptores podrían usar LLMs para resumir muchas capas de texto y localizar información relevante a través de una gran base de datos de pólizas.

Estos son solo algunos de los aplicaciones en constante aumento para los LLMs, que en conjunto mejorarían significativamente las eficiencias operativas. Con la aplicación correcta, los LLMs podrían ser una herramienta esencial para casi todos los aspectos de la industria de seguros.

Enfoques más efectivos para los LLMs

Los usuarios tienen cuatro opciones para incorporar sus datos en LLMs, cada opción requiere diferentes grados de complejidad y recursos computacionales.

Entrenar. La opción más desafiante y costosa es entrenar LLMs desde cero, lo que requiere un inmenso volumen de datos de entrenamiento y poder computacional para encontrar la configuración más óptima para una red neuronal novedosa.

Afinar. Dados estos enormes costos, un enfoque más común es tomar un modelo que ha sido preentrenado para el procesamiento de lenguaje natural y afinar sus pesos usando datos propietarios y conocimiento corporativo. Aunque este enfoque producirá un modelo personalizado adaptado a las necesidades de su desarrollador, los recursos computacionales requeridos para el reentrenamiento del modelo todavía pueden ser un gasto desproporcionado para la mayoría de las grandes empresas.

RAG. La generación aumentada por recuperación (RAG, por sus siglas en inglés) es una técnica más nueva y coste-efectiva para incrustar más información en un solo prompt. RAG funciona transcribiendo el texto de un documento en una representación numérica (a través de word embedding) y luego agregando todos los vectores resultantes en una base de datos. Esta base de datos vectorizada contiene relaciones semánticas a través del documento. Los usuarios pueden entonces buscar en la base de datos piezas de información relevantes para un prompt dado. Al aumentar prompts usando RAG, los usuarios proporcionan a los LLMs un contexto mayor para que puedan generar respuestas personalizadas sin la necesidad de que los usuarios ajusten directamente los pesos del modelo.

Ingeniería de prompts. La manera más directa y económica de usar LLMs es la ingeniería de prompts, donde los usuarios individuales exploran y elaboran cuidadosamente prompts que generan las respuestas más útiles.

Oportunidades y limitaciones de la IA

Recientemente, los LLMs han ganado la capacidad de interpretar y analizar archivos CSV. Al examinar conjuntos de datos específicos, estos modelos pueden proporcionar perspectivas personalizadas y generar fragmentos de código a medida para el análisis de datos o visualización, permitiendo un enfoque más contextual y específico de datos. Por ejemplo, basado en la estructura, tipo y tendencias dentro de un archivo CSV, un LLM puede sugerir análisis estadísticos relevantes, identificar métodos de limpieza de datos apropiados o incluso predecir resultados potenciales. Este nivel de personalización es pivotal para tomar decisiones más informadas y simplificar las etapas iniciales de la exploración de datos.

Sin embargo, es importante distinguir este enfoque LLM de la Automatización del Aprendizaje Automático (AutoML). AutoML se centra en automatizar el proceso de punta a punta de aplicar el aprendizaje automático a problemas del mundo real. Los sistemas AutoML pueden seleccionar el mejor modelo, aplicar ajuste de hiperparámetros y completar selecciones de características, todo con mínima intervención humana. En contraste, el código generado por LLM para análisis de datos es más sobre guiar y asistir en tareas específicas en lugar de automatizar todo el proceso. Un enfoque híbrido que combine ambos podría ser altamente beneficioso: LLMs podrían asistir en la comprensión inicial de datos y el preprocesamiento, mientras que AutoML podría encargarse de la selección y optimización del modelo. Esta sinergia podría conducir a flujos de trabajo de aprendizaje automático más eficientes, precisos y accesibles, haciendo el análisis de datos avanzado más abordable para no expertos y más eficiente para practicantes experimentados.

También es probable que las tecnologías de IA generativa sufran una convergencia drástica. Actualmente, se utilizan redes neuronales muy distintas para la generación de imágenes, generación de texto, generación de audio y coches autónomos. La tecnología futura probablemente unificará estas aplicaciones a medida que avanzamos hacia capacidades de IA generales. La IA general funcionaría de manera similar a nuestros propios cerebros, con una tecnología logrando casi todas las tareas. Y aunque los LLMs no razonan, al menos no al grado de los humanos, el razonamiento computacional es otro avance clave que podría estar en el horizonte.

Conclusión

Todos los indicios apuntan a que 2024 será otro año de rápido crecimiento para la IA generativa. La IA generativa será tan impactante como la revolución de internet, y es importante que los profesionales del seguro adopten estas tecnologías emergentes en esta nueva era.